普大喜奔!免费使用 llama3.1的八个网站

又一个重量级大模型发布,波谲云诡的AI江湖再添变数

这是一款强大的开源 AI 模型,由知名科技公司 Meta(之前叫 Facebook)发布。Llama 3.1 ,一共三个版本, 包括 8B、70B、405B

今天我向您简介这款AI,并分享八个免费使用 Llama 3.1 的方法,其中3个国内直联、支持405B!

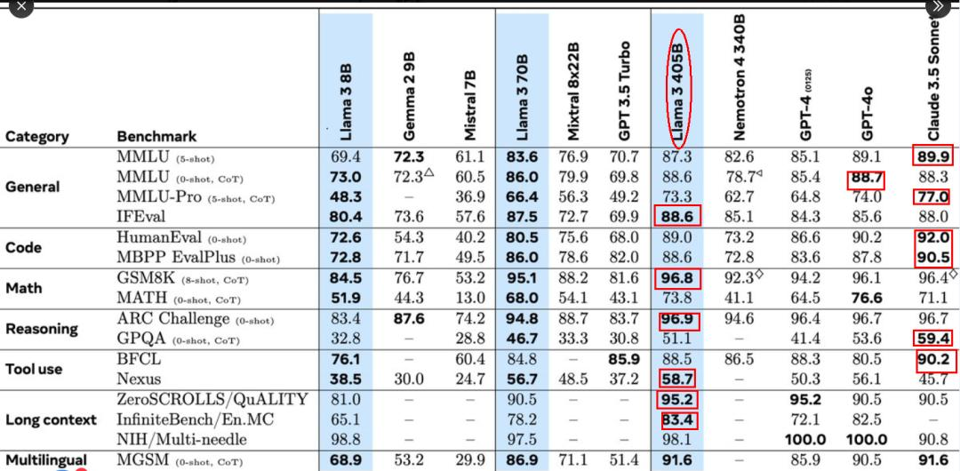

以下是官方公布的测试数据,水平 与gpt4o、claude3.5 sonnect 旗鼓相当

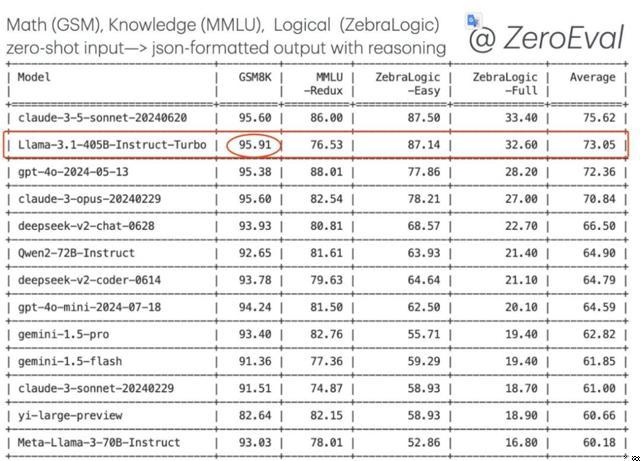

第三方评测机构,除坚持用户盲测打分的LMsys暂未给出排名外,SEAL 和 Allen AI 的 ZeroEval 两个独立评估机构给出了自己的结果,405B 确实厉害!SEAL 上405B指令遵循主流AI中第一、代码第四、数学第二

ZeroEval 测试它整体性能介于 Sonnet 3.5 和 GPT4o 之间。

官方博客: llama.meta.com/llama3

申请下载: llama.meta.com/llama-downloads

一、开源 AI 和闭源 AI 大战

在 AI 的世界里,有两个阵营:开源 AI 和闭源 AI。开源 AI 像是一个巨大的图书馆,任何人都可以进去学习、分享和改进知识。闭源 AI 则像是私人图书馆,只有特定的人才能进入。什么是开源呢?就是代码和数据是公开透明的,任何人都可以下载使用和改进。开源 AI 模型和普通商业 AI 模型不太一样。开源的好处是,大家可以一起分享知识,互相合作改进模型。成本也会更低,让更多人和小型公司参与进来。而且开源的模型更加透明,人们更容易相信和信任。相比之下,商业 AI 模型的代码和数据都是保密的,只有公司自己掌控,定价也更高。但这样可以提供更专业定制的服务。

开源 AI 的优势:

共享与协作:全球的研究者和开发者可以一起工作,让模型变得更好。

SEAL 上405B指令遵循主流AI中第一、代码第四、数学第二

ZeroEval 测试它整体性能介于 Sonnet 3.5 和 GPT4o 之间。

官方博客: llama.meta.com/llama3

硬件配置 要求中等,下载到本地,苹果M1、16G显卡就能本地运行后,免费使用!

让我们一起来看看 llama3.1是如何改变游戏规则的,以及我们个人用户如何能够使用它。

关键是,如果你有能力本地部署,它还是完全免费的!

在 AI 的世界里,有两个阵营:开源 AI 和闭源 AI。

什么是开源呢?就是代码和数据是公开透明的,任何人都可以下载使用和改进。

相比之下,商业 AI 模型的代码和数据都是保密的,只有公司自己掌控,定价也更高。但这样可以提供更专业定制的服务。

- 共享与协作:全球的研究者和开发者可以一起工作,让模型变得更好。

- 成本效益:不需要很多钱就能使用这些模型,小公司和个人也能参与。

- 透明度:我们知道它是如何工作的,这让我们更信任它。

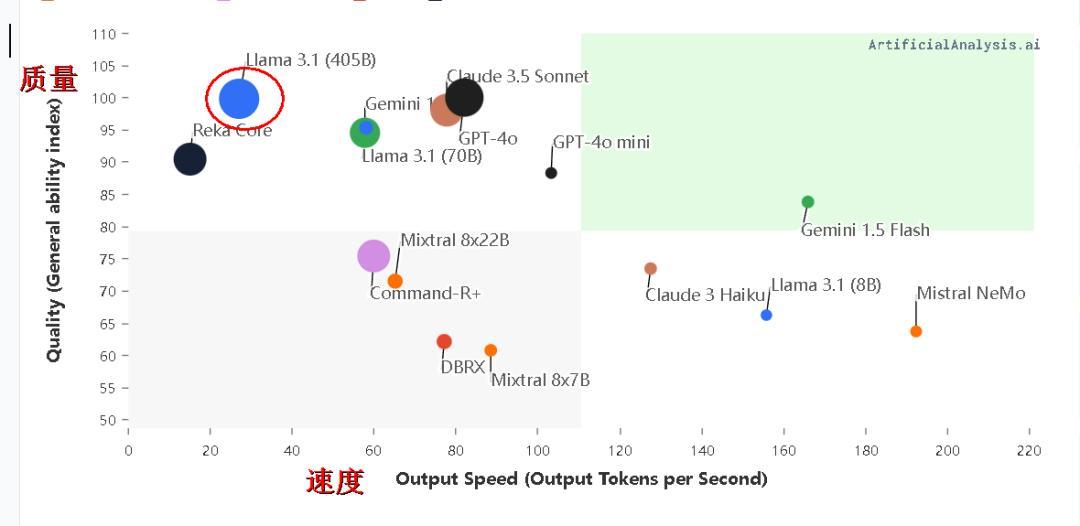

主流AI大模型速度-性能- 价格分布图如下:

闭源 AI 的特点:

- 专有技术:由一家公司控制,他们不告诉别人它是怎么做的。

- 定制化服务:可以提供特别为你设计的服务。

- 盈利模式:通过订阅费或授权使用费来赚钱。

常见闭源软件有 ChatGPT、Claude、谷歌 gemini、kimi 等

meta 是一个商业盈利机构,但是为了构建元宇宙,它买了最多的显卡,给大家训练了一个开源 AI 大模型 llama 系列!

二、llamma3 的使用

现在,让我们看看如何使用 llama3.1。

(一)本地使用:

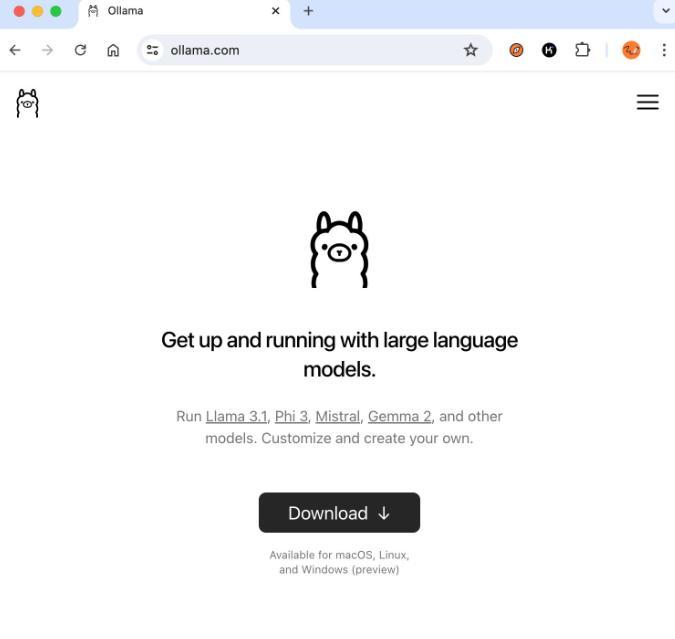

- ollma 部署:如果你想在自己的电脑上使用 llama3,可以下载模型并进行本地部署。

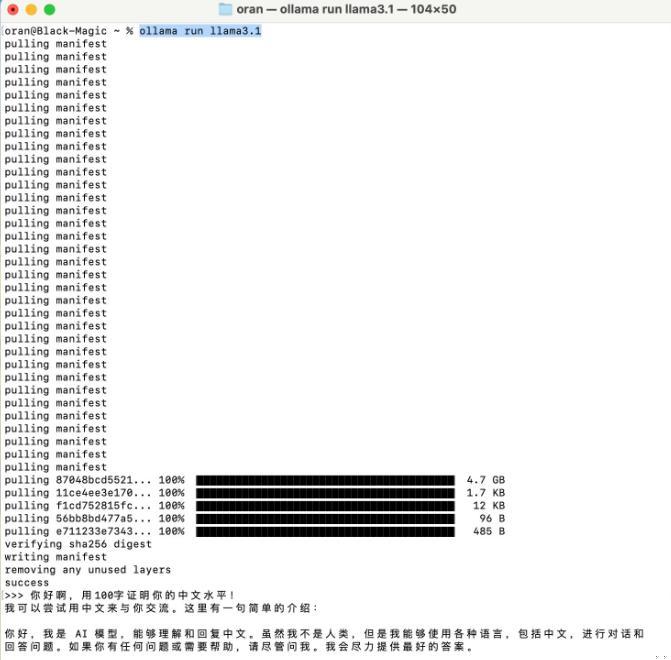

1、安装和启动 Ollma

访问 https://ollama.com/download

下载适合自己系统的 Ollma 客户端。

2、运行 Ollma 客户端,它会在本地启动一个 API 服务。

在 Ollma 中,可以选择运行 LLaMA 3.1 模型

打开终端,输入:ollama run llama3.1

3、输入问题,开始使用

本地API使用 :

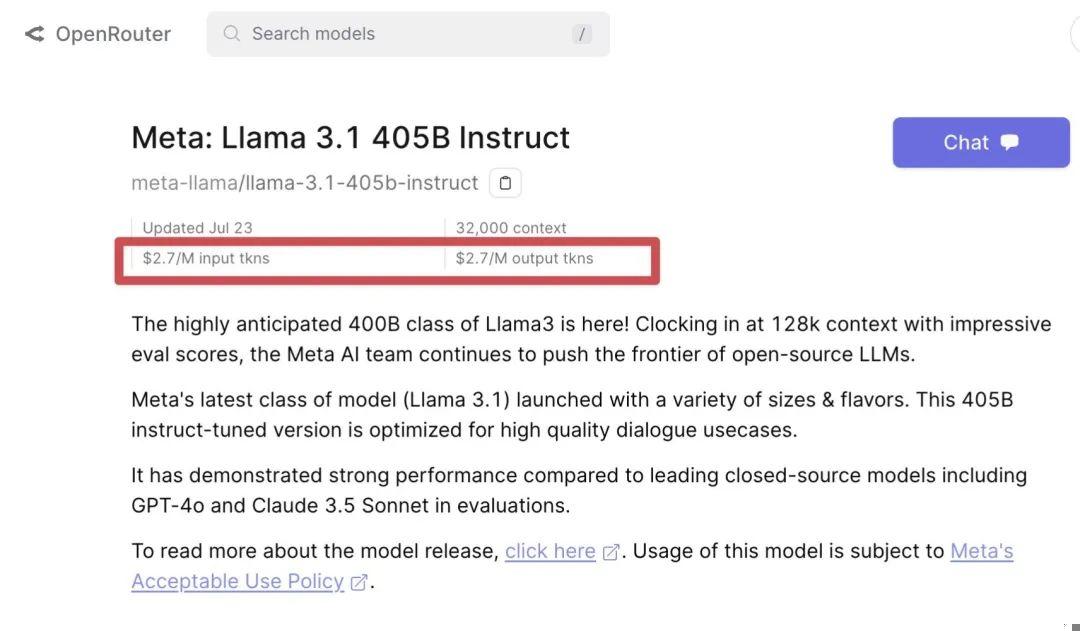

到第三方去购买API,然后在本机安装一个chatnextweb软件。

第三方API的价格目前是gpt4o的50%,大概2.5~3美元每百万token。

(二)在线使用

1、Meta 官网

国内直联:否

登录难度:极大

登录网址:www.meta.ai

响应速度:中等

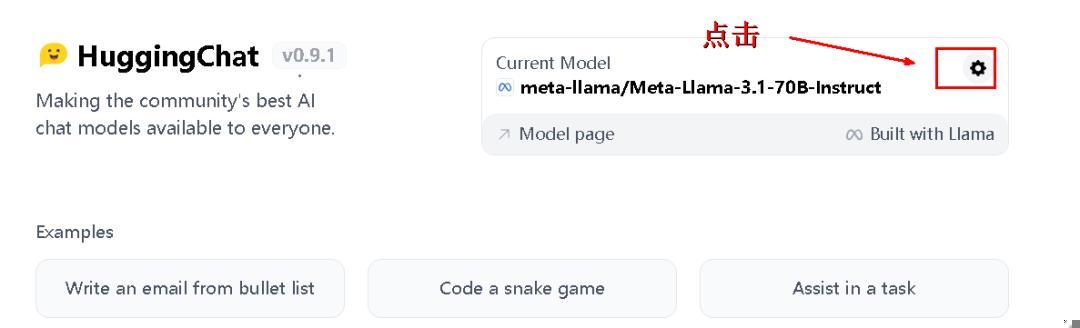

2、抱抱脸 HuggingChat(推荐)

国内直联:否

登录难度:中

登录网址:huggingface.co/chat/

响应速度:中等

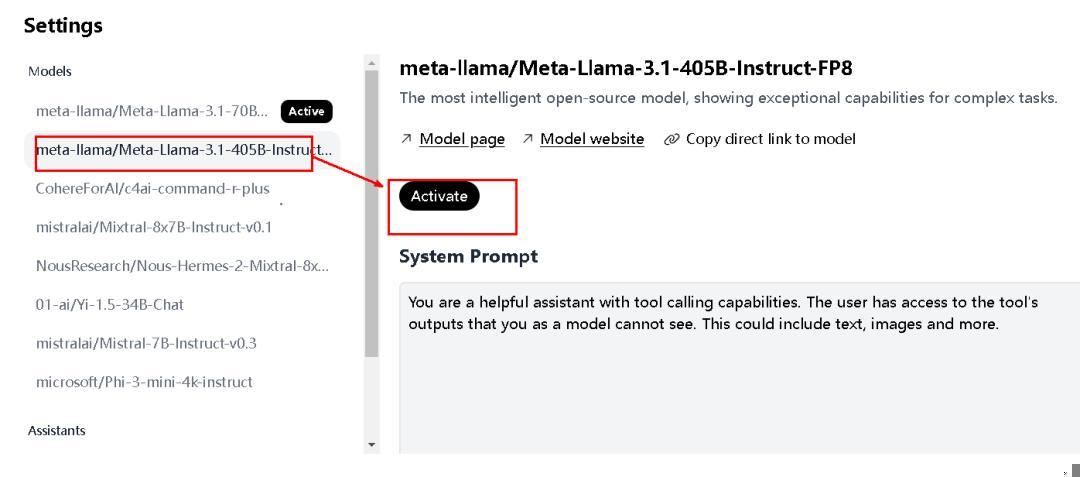

打开界面上的“设置”齿轮,选中 LLaMA3.1,点击“Activate”,输入系统提示“用中文回复”,关闭窗口,搞定!

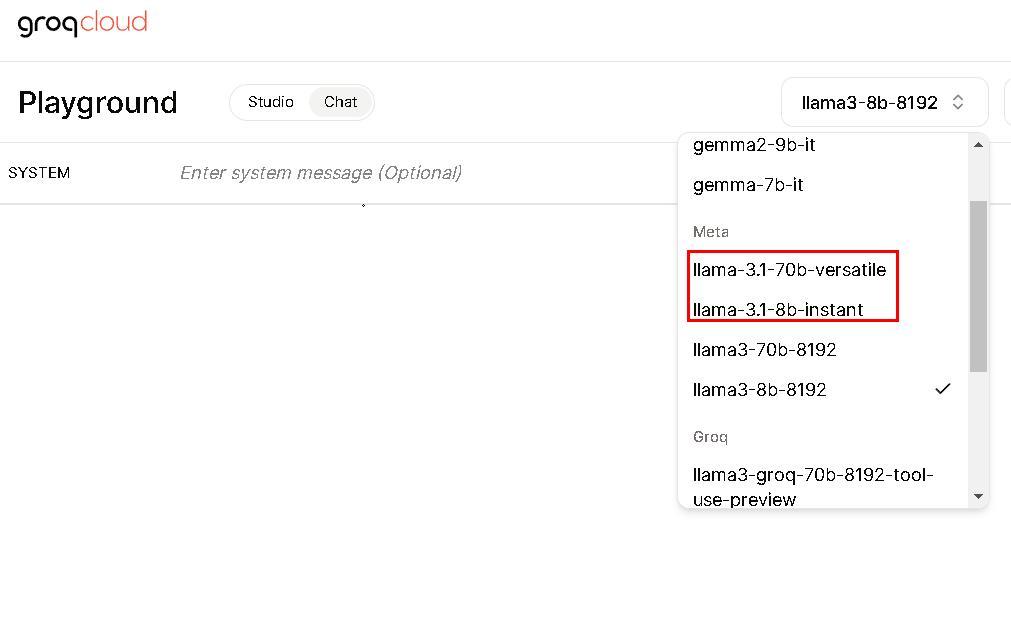

3、Groq 平台

Groq 是一家专注于开发高效能 AI 推理硬件的公司,其产品旨在为机器学习工作负载提供高性能和低功耗的解决方案,开发了一种名为LPU的专用芯片,专门针对大型语言模型(LLM)的推理进行优化。

国内直联:否

登录难度:中

登录网址:console.groq.com

响应速度:中等

使用界面:

需要选中 LLaMA-3.1,405B暂时下架,估计过两天会恢复

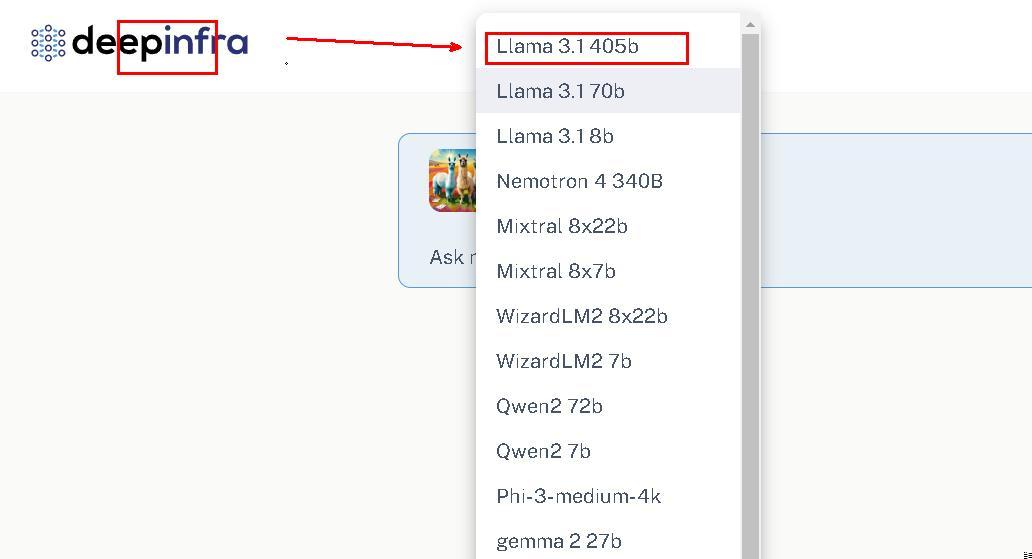

4、deepinfra 平台

DeepInfra 是一个提供机器学习模型和基础设施的平台,它专注于提供快速的机器学习推理(ML Inference)服务。注册送1.5美元API 额度。也可在线使用

国内直联:否

登录难度:中

登录网址:deepinfra.com/meta-llama/

响应速度:中等

使用界面:

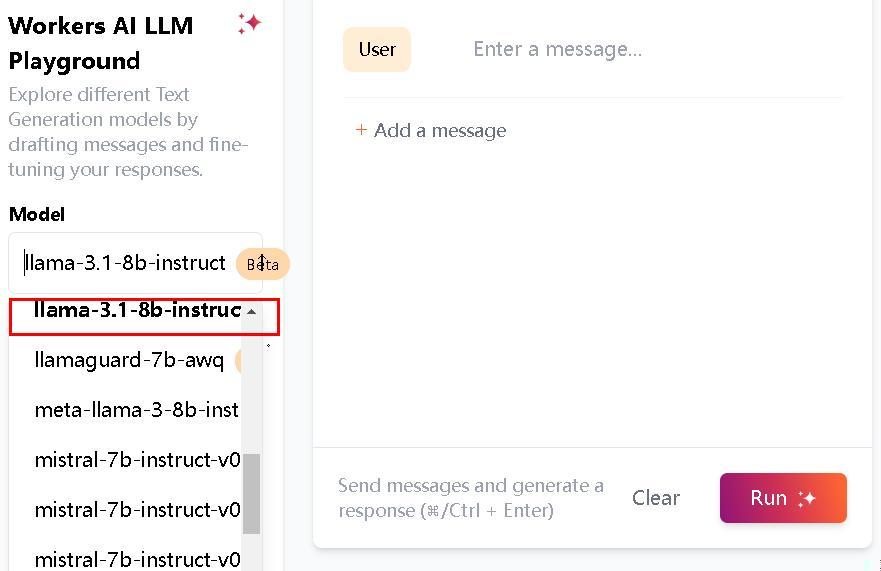

5、cloudflare 平台(国内直联)

Cloudflare 是一家大名鼎鼎提供互联网安全、性能优化和相关服务的公司

国内直联:是

登录难度:中

登录网址:

playground.ai.cloudflare.com/

响应速度:中等

使用界面:

需要选中 LLaMA-3.1 ,目前只有 8B 版本

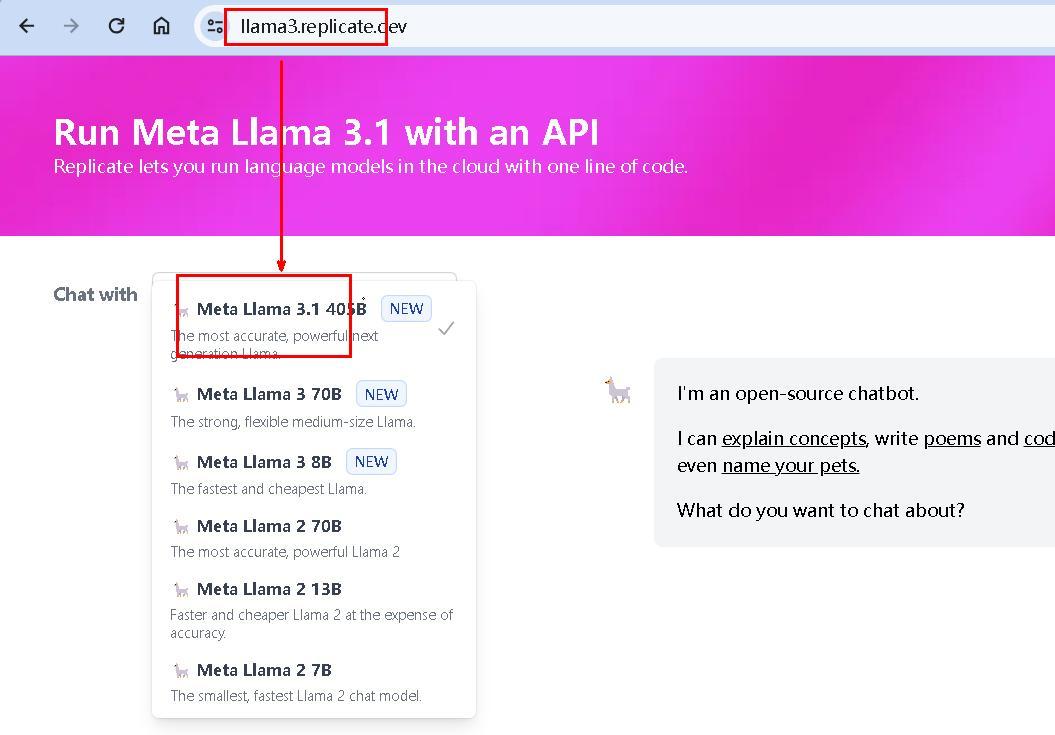

6、Repilcate 平台(推荐,国内直联)

国内一个面向机器学习和人工智能模型的在线平台,专注于提供模型的部署、运行和训练服务

国内直联:是 :)

登录难度:小,国内直联,支持405B

登录网址:llama3.replicate.dev

https://replicate.com/meta/meta-llama-3-70b-instruct

响应速度:中等

使用界面:

需要选中 LLaMA-3.1

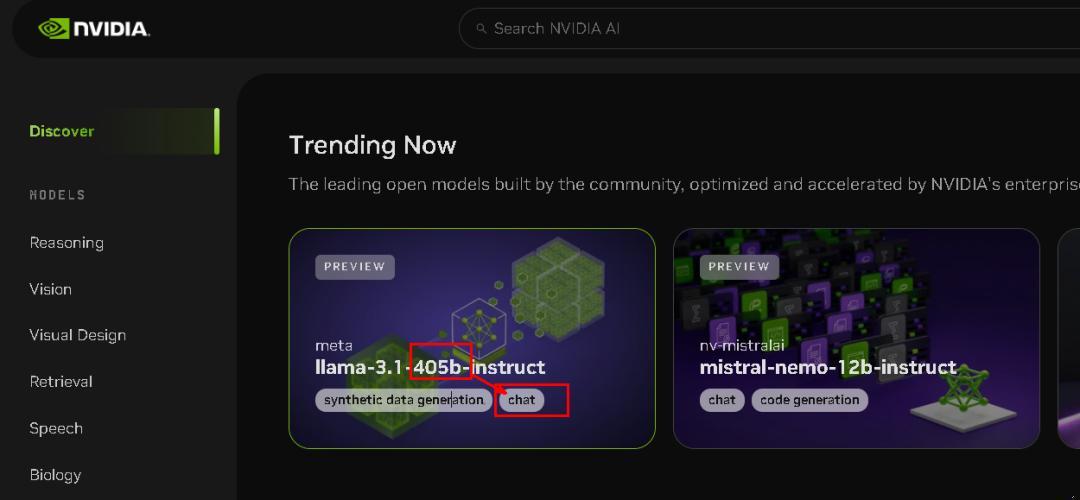

7、英伟达平台(国内直联)

英伟达公司不用介绍了吧

国内直联:是 :)

登录难度:小,,国内直联,支持405B

登录网址:

https://build.nvidia.com/explore/discover#llama-3_1-405b-instruct

响应速度:中等

使用界面:

需要选中 LLaMA-3.1

8、中文 llama 社区(国内直联)

中文 llama 社区

国内直联:是 :)

登录难度:小,国内直联,支持405B

登录网址:llama.family/chat

响应速度:70B(8B 很快)

使用界面:

这次 llama3.1 的发布,就看其他厂商如何应对了,估计 AI之王 GPT5 快出关了!

好啦,今天的分享就到这里!

转载请注明出处,本文地址:https://www.iiilab.com/article/794390765